Voir les articles précédents : Partie 1 - Partie 2

En répondant à la question posée par le titre de cet essai, le chapitre du mois dernier, la partie 2, a abordé le problème par l'étude anthropologique, la diffusion des innovations, et nous a expliqué comment le changement se produit dans les sociétés. Ces anthropologues ont découvert que, dans les diverses cultures, on peut trouver des groupes dont l'ouverture à de nouvelles idées et technologies est variable - groupes que l'on peut représenter par une jolie courbe en cloche. Le succès de la diffusion d'une technologie innovante ou d'une idée nouvelle dépend essentiellement d'un point : si oui ou non les leaders d'opinion vont se porter garant pour elle. Dans ce contexte, les médias grand public peuvent à juste titre être considérés comme des vecteurs de la promotion du mythe officiel du 9/11, et ont donc aidé et encouragé les crimes du 11 Septembre 2001.

Nous continuons l'analyse de Mme Shure dans la partie 3 avec les expériences sur l'autorité menées par Stanley Milgram, Jane Elliott, et Philip Zimbardo. Dans sa célèbre expérience consacrée à l'obéissance à l'autorité en 1961 (1), le psychologue de l'Université de Yale Stanley Milgram a entrepris de répondre aux questions suivantes : « Se pourrait-il que Eichmann et ses millions de complices de l'Holocauste aient tout simplement suivi des ordres ? Peuvent-ils être tous considérés complices ? »

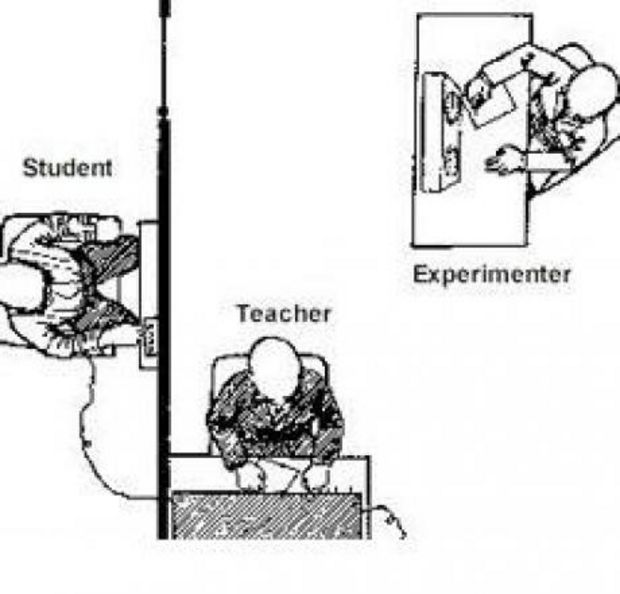

Trois personnes composaient chacune des expériences de Milgram : l'expérimentateur (l'autorité) ; le sujet de l'expérience, un bénévole à qui il avait été dit qu'il ou elle était un « enseignant » ; et un complice (que l'on appelle une « plante ») que le sujet pensait être un « étudiant » ou un « apprenti », mais qui était en réalité un acteur.

Le « professeur » (le sujet) envoyait une légère décharge électrique que l'« étudiant » (acteur) était supposé recevoir. Ensuite, le professeur lisait une liste de paires de mots à l'étudiant, et l'étudiant devait appuyer sur un bouton pour donner sa réponse. Si la réponse était correcte, l'enseignant passait à la prochaine liste de paires de mots, mais si la réponse était fausse, l'enseignant était chargé d'administrer une décharge électrique à l'étudiant. Cela continuait avec des décharges augmentant de 15 volts pour chaque réponse incorrecte successive. En réalité, aucune décharge n'était effectivement administrée, mais des sons pré-enregistrés de cris de douleur étaient diffusés lors de certaines décharges. À un niveau élevé des décharges supposées, l'acteur frappait sur le mur le séparant de l'enseignant, et se plaignait de son état cardiaque. A un niveau de décharges encore plus élevé, tous les sons de l'étudiant avaient cessé.

Chaque fois qu'un enseignant voulait arrêter l'expérience, l'autorité disposait d'un ensemble prédéterminé de réponses verbales, données dans cet ordre :

1. S'il vous plaît continuez.

2. L'expérience exige que vous continuiez.

3. Il est absolument essentiel que vous continuiez.

4. Vous n'avez pas d'autre choix. Vous devez continuer.

Si, après la quatrième réponse, le sujet insistait toujours sur son désir d'arrêter, l'expérience était interrompue. Sinon, l'expérience prenait fin seulement lorsque le sujet adressait ce qu'il pensait être une décharge maximale de 450 volts trois fois de suite.

Ces résultats étonnèrent les participants d'un sondage précédent, donné aux étudiants en dernière année de psychologie à Yale, les collègues de Milgram et certains psychiatres locaux, qui avaient tous prédit qu'une très petite fraction des sujets aurait d'administré la décharge maximale. Car Milgram a mis en évidence qu'environ les deux tiers de ses sujets auraient volontiers administré ce qu'ils pensaient être la décharge maximale, potentiellement mortelle, de 450 volts à un « étudiant », bien que beaucoup étaient très mal à l'aise au moment de le faire.

Dans son article, « Les dangers de l'obéissance », Milgram a résumé les résultats de son étude révolutionnaire :

« L'autorité rigide affrontait les forts impératifs moraux des sujets de ne pas blesser les autres, et, malgré les cris des victimes dans les oreilles des sujets, l'autorité l'a remporté le plus souvent. L'extrême détermination des adultes à répondre à presque tous les ordres d'une autorité constitue le point d'orgue de l'étude, et le fait demandant le plus urgemment des explications. » (2)Une version modifiée de cette expérience a révélé quelques bonnes nouvelles à ceux d'entre nous confrontés aux mensonges et aux abus des autorités : dans une variante, trois enseignants (deux acteurs et un sujet réel) géraient le test et les décharges. Lorsque les deux acteurs désobéissaient à l'expérimentateur et refusaient d'aller au-delà d'un certain niveau de décharge, trente-six des quarante sujets rejoignirent leurs pairs désobéissants et refusèrent également. (3)

La leçon pour les sceptiques du 9/11 n'est pas difficile à comprendre : si nous continuons à aller au delà de nos propres barrières tabous, au delà de la résistance des autres, et que nous continuons de parler en toute confiance de notre vérité avec des informations étayées, nos pairs à travers le monde se joindront progressivement à nous.

Néanmoins, les données provenant des expériences originales de Milgram peuvent toujours nous « choquer », comme cela a été le cas dans le monde des années 1960. Pour moi, en tant qu'étudiante de premier cycle, il était inquiétant et bouleversant d'entendre que les deux tiers d'entre nous auraient administré une décharge potentiellement mortelle à une personne impuissante et malade : ayant été élevée par des parents clairement autoritaires, je savais qu'il était probable que j'eus également suivi ces ordres ! Je résolus donc de ne jamais suivre aveuglément l'autorité, mais plutôt d'écouter et de faire confiance à mon intime conviction et à ma conscience.

Mais ces conclusions s'appliquent-elles au point de croire fermement ce qu'une autorité nous dit ? Nous pourrions parfois soupçonner que nous suivons les ordres d'une autorité, mais que nous ne croyons pas toujours intimement ce que cette autorité proclame (par exemple, que 19 musulmans nous ont attaqués parce qu'ils détestent nos libertés). Mais des données empiriques montrent pourtant que ces résultats s'appliquent bien, surtout si notre peur s'est intensifiée et que nous respectons cette autorité en particulier (par exemple, George W. Bush ou Barack Obama).

Une expérience sociale étonnante menée par l'enseignante de « troisième année » [Ndt : équivalent à une classe de CM1, âge 8-9 ans] Jane Elliott démontre la puissance de notre propension humaine à croire une autorité établie, et même à développer notre identité en nous basant sur ce que cette autorité nous dit sur nous-mêmes. Après l'assassinat de Martin Luther King Jr. [1968], Elliott voulut aider ses élèves d'une communauté blanche d'une petite ville de l'Iowa à comprendre les préjugés. Un jour, elle leur dit :

« Aujourd'hui, les personnes aux yeux bleus seront au fond et les personnes aux yeux bruns devant. Ce que je veux dire c'est que les gens aux yeux bruns sont meilleurs que les gens aux yeux bleus. Ils sont plus propres que les personnes aux yeux bleus. Ils sont plus civilisés que les personnes aux yeux bleus. Et ils sont plus intelligents que les personnes aux yeux bleus. »

Les personnes aux yeux bruns étaient autorisées à rester plus longtemps en pause, à utiliser le terrain de jeu plus grand, et étaient prioritaires pour déjeuner et pour un second service. Elliott a donné pour instructions aux personnes aux yeux bleus de ne pas jouer avec les gens aux yeux bruns, à moins de le demander, et de s'asseoir dans le fond de la salle. Chaque enfant aux yeux bruns s'est vu remettre un collier à mettre autour du cou d'un enfant aux yeux bleus. Tout au long de la journée, l'enseignante a ressassé que les enfants aux yeux bruns étaient des enfants supérieurs et que ceux aux yeux bleus étaient inférieurs.

A midi, l'unique comportement des enfants montrait s'ils avaient les yeux bleus ou bruns : les enfants aux yeux bruns étaient heureux, alertes, profitant de la vie. Et ils produisaient un travail bien meilleur qu'ils ne l'avaient jamais fait auparavant. Les enfants aux yeux bleus étaient malheureux. Leurs postures, leurs expressions, toutes leurs attitudes étaient celles de la défaite. Leur travail en classe a fortement régressé par rapport à la veille. En une heure ou deux, ils semblaient inférieurs et agissaient, de fait, comme s'ils l'étaient. C'était choquant.Mais ce qui était encore plus effrayant était la façon dont les enfants aux yeux bruns s'étaient retournés contre leurs amis de la veille... (4) Jane Elliott a inversé l'expérience le lendemain, étiquetant les enfants aux yeux bleus comme supérieurs, et la même chose s'est produite dans le sens inverse.

À la fin de la journée, elle a dit à ses élèves que c'était seulement une expérience et qu'il n'y avait aucune différence entre les personnes aux yeux bleus et aux yeux bruns. Les enfants ont enlevé leurs colliers et se sont étreints, se sentant grandement soulagés d'être égaux et de nouveaux amis. Un aspect intéressant de l'expérience est comment cela a affecté leur apprentissage .... Une fois que les enfants ont réalisé que leur pouvoir d'apprendre dépendait de leurs propres convictions, ils étaient persuadés d'être intelligents et de ne pas se laisser avoir une nouvelle fois. (5)

Bien évidemment, on pourrait penser que les adultes seraient à l'abri de telles pressions sociales et de telles manipulations, non ? Les adultes ne seraient-ils pas capables de discerner et de résister à ce à quoi les enfants ne peuvent pas ? Certainement, en tant qu'adultes, notre identité ne serait pas affectée par de telles manipulations, n'est ce pas ?

Dans une étude remarquablement similaire à l'enseignante de troisième année Jane Elliott, la célèbre expérience de la prison de Stanford menée par le psychologue social Philip Zimbardo dans le début des années 1970 montre que cette hypothèse parfaitement admissible est erronée. Zimbardo et ses collègues ont utilisé 24 étudiants de sexe masculin en tant que sujets, en les divisant arbitrairement en « gardiens » et « détenus » dans une fausse prison. Zimbardo a chargé les « gardiens » d'agir avec oppression envers les « prisonniers », en clair d'endosser le rôle d'une autorité.

Tous les étudiants savaient que c'était une expérience, mais surprenant même les expérimentateurs, ils se sont néanmoins rapidement imprégnés de leurs rôles de gardiens sadiques, brutaux, brisant émotionnellement les prisonniers. Le « système carcéral » mis en place par les expérimentateurs et la dynamique subséquente qui s'est développée a eu un effet tellement délétère parmi les sujets que l'étude a pris fin le sixième jour. Cependant, cela n'arriva que lorsque l'étudiante diplômée en psychologie Christina Maslach - avec laquelle Philip Zimbardo sortait et qui par la suite est devenue son épouse - portât à sa connaissance les conditions de l'expérimentation contraires à l'éthique. (6)

Tout comme les études de Milgram et Elliott, cette expérience démontre la tendance humaine à croire et à suivre l'autorité. Les études de Zimbardo et Elliott démontrent que nos identités mêmes sont impactées par ce que l'autorité nous dit et que cette pression de nos pairs renforce grandement ces tendances humaines. En conséquence, les sujets de Milgram, les élèves de troisième année de Elliott, et les étudiants adultes de Zimbardo ont commis des atrocités, y compris en violation de valeurs morales fortes.

Zimbardo est devenu un témoin expert de la défense pendant la Cour Martiale de l'un des gardiens de nuit de l'infâme groupe des « Sept d'Abu Ghraib », Ivan "Chip" Frederick. En raison de son expérience avec l'histoire de la Prison de Stanford, Zimbardo a fait valoir que c'était la situation qui avait généré ces comportements aberrants chez des gens d'ordinaire bons. Alors que l'armée décrivait ces gardes comme quelques « pommes pourries » dans un pourtant bon cageot de l'armée américaine, Zimbardo a fait valoir que ces gardiens étaient tout à fait normaux, de bonnes pommes dans un cageot pourri.

Chip Frederick a plaidé coupable et a été condamné à une peine de huit ans de prison, le témoignage de Zimbardo n'ayant eu que peu d'effet sur la sentence. Les autres gardes, reconnus coupables, furent condamnés à des peines allant de zéro à dix ans ; la différence dans les quantum de peines semblait n'avoir aucun sens.

Quelle est la vérité ? Ces gardiens de nuit étaient-ils seulement quelques « pommes pourries » dans un bon cageot, ou le cageot lui-même était-il pourri ? L'armée elle-même a déclaré que, depuis Octobre 2001, on comptait plus de 600 accusations de mauvais traitements sur des détenus. Bien d'autres n'ont pas été signalés, y compris les abus envers des « détenus fantômes », ces malheureuses personnes qui, sous le contrôle de la CIA, n'ont jamais été identifiées et ont souvent été « fournies » pour torture d'État. Beaucoup de ces victimes étaient simplement portées « disparues ». Par extension, il y avait évidemment aussi beaucoup d' « agresseurs fantômes », lesquels n'ont jamais été reconnus responsables.

Pour appuyer son accusation selon laquelle le cageot, plutôt que les pommes, était pourri, Zimbardo a mis le système lui-même à l'essai dans « l'Effet Lucifer » (7). Il a constaté que les ordres, les attentes, et la pression de la torture venaient du sommet de la chaîne de commandement, et ses analyses mettaient en évidence la culpabilité du Secrétaire à la Défense Donald Rumsfeld, du directeur de la CIA George Tenet, du lieutenant général Ricardo Sanchez, du général Geoffrey Miller, du vice-président Dick Cheney, et du président George W. Bush.Pourquoi certaines personnes agissent conformément aux attentes du système tandis que d'autres trouvent le courage de rester fidèles à leurs principes ? Tout au long de cet essai apparaissent des éléments de réponse dans la perspective du développement de la psychologie profonde, mais explorer ce sujet extrêmement important en détail nécessiterait un travail séparé. Zimbardo, cependant, a commencé cette exploration du point de vue d'un psychologue social, déclarant que nous sommes tous des « héros potentiels », et il a offert des pistes sur la façon de résister aux influences sociales indésirables. (8)

Les analyses détaillées de Zimbardo concluent que « ce cageot de pommes a commencé à pourrir de haut en bas. » Pourtant, il fait aussi l'éloge de nombreux héros, ces dénonciateurs du bas vers le haut de la hiérarchie militaire, ces êtres humains qui ont risqué leur vie et leur carrière en se levant et se montrant déterminé face à ce système toxique. (7)

Mon intime conviction est que les sceptiques du 9/11 - et tous les vrais sceptiques devant n'importe quel changement de paradigme et n'importe quel sujet tabou - qui exposent publiquement les mensonges et les mythes [Ndt : littéralement « empereurs nus » (12)] sont des héros qui se sont réveillés, malgré que nous avons souffert du ridicule et de la colère de ces empereurs, de leurs serviteurs, et tout simplement de la peur.

Ces trois études - l'étude de Milgram sur l'obéissance à l'autorité, l'expérience des Yeux bleus / Yeux bruns d'Elliott, et l'expérimentation de la Prison de Stanford menée par Zimbardo - démontrent notre propension humaine à faire confiance et à obéir à l'autorité. Une autre question se pose à nous : est-ce que cette prédisposition est génétique ? Des preuves apparaissent à l'appui de cette hypothèse.

Pour survivre en tant que bébés et jeunes enfants, nous sollicitons systématiquement nos parents pour apprécier la sécurité ou le danger.

Les chimpanzés, avec lesquels notre patrimoine génétique est commun à au moins 94% (9), ont généralement un ou plusieurs mâles dirigeants Alpha, bien que ceux-ci soient souvent choisis par les femelles de la troupe (10). Les bonobos, avec un génome proche de celui des chimpanzés et donc de l'homme, disposent d'un système matriarcal avec une femelle à la tête du groupe (11).

Et, bien sûr, les communautés humaines ont des dirigeants. Ainsi, la nécessité d'un chef, d'une autorité, semble être génétiquement encodée. Si nous avons été élevés dans un cocon familial autoritaire et que avons suivi un cursus scolaire de même nature, alors cette tendance à compter sur des figures autoritaires pour apprécier la réalité est probablement renforcée. Inversement, si nous sommes élevés dans une famille, un système scolaire, et un contexte culturel qui promeut l'esprit critique et respecte nos sentiments et nos besoins, alors la tendance à compter sur des figures autoritaires serait susceptible d'être amoindrie.

Dans notre société américaine, beaucoup de nos représentants officiels nous mentent régulièrement pour nous abuser. Néanmoins, de nombreux citoyens continuent à se tourner vers eux pour obtenir la vérité et la sécurité, surtout quand leur peur est accentuée. Cette forte tendance à croire et à obéir à l'autorité est un autre obstacle avec lesquels les sceptiques de la version officielle du 9/11 doivent composer.

En obéissant et en croyant aveuglément l'autorité, nous développons et perpétuons des identités erronées, des mythes, et pour couronner le tout, nous prenons de très mauvaises décisions, qui affectent souvent négativement les autres. Cela peut également s'appliquer pour les quatre prochains penchants humains étudiés par les psychologues sociaux : la double pensée, la dissonance cognitive, la conformité, et la pensée de groupe.

Notes :

(1) Stanley Milgram, obéissance à l'autorité : une approche expérimentale (Harper & Row Publishers, Inc., 1974).

(2) Stanley Milgram, « Les périls de l'obéissance » Harpers Magazine (1974). Peut être consultée http://www.age-of-the-sage.org/psycholo ... 1974.html

(3) Ibid.

(4) Dennis Linn, Sheila Fabricant Linn, et Mathew Linn, « Cicatriser le futur : le rétablissement personnel des blessures sociétales » (Paulist Press, 2012) 56-60. William Peters, A Class Divided : Then and Now, éd élargi. (New Haven : Yale University Press, 1971) ; ce livre comprend un apport de Jane Elliott qui a mené une expérience similaire avec des adultes employés dans du Iowa Department of Corrections. Des documentaires évoquant aussi cette histoire sont « L'oeil du Cyclone », ABC Nouvelles, 1970, distribué en DVD par Admire Productions, 2004, http://www.admireentertainment.com, et une classe divisée, par Yale University Films, 1986 , présenté sur Frontline et distribués en DVD par PBS Home Video, www.pbs.org ; les deux programmes comprennent des guides d'étude pour une utilisation en groupes.

(5) Dennis, Sheila, et Matthew Linn, Guérir l'avenir, 57-58.

(6) Philip Zimbardo, L'effet Lucifer : comprendre comment de bonnes personnes sont capable de faire du mal (Random House Trade Paperbacks, 2008). Aussi, voir http://www.simplypsychology.org/zimbardo.html

(7) Zimbardo, « l'Effet Lucifer », 324-443.

(8) Ibid, 444-488.

(9) http://www.scientificamerican.com/artic ... e-gap-wide

(10) http://en.wikipedia.org/wiki/Chimpanzee

(11) http://en.wikipedia.org/wiki/Bonobo

(12) Expression utilisée pour désigner une situation où beaucoup de personnes croient quelque chose qui n'est pas vrai (voir http://www.urbandictionary.com/define.php?term=the+emporer+has+no+clothes)

Commentaire : Quelques liens supplémentaires pour étoffer une réflexion :

- Le cyranoid, manipulation et tromperie humaine

- Désinformation