Du biais des mesures aux biais cognitifs

Les longues séries de données climatiques comportent des biais. Les biais sont des erreurs systématiques dues à des imperfections du dispositif instrumental et/ou aux conditions inadaptées dans lesquelles l'évaluation ou la mesure a lieu. La recherche obsessionnelle du signal anthropique dans les données climatiques conduit à un biais tout aussi redoutable : le biais de confirmation qui incite à chercher constamment des raisons de continuer à croire ce que l'on croit déjà.

Lors d'une conférence donnée au Bureau des Longitudes le 7 octobre 2009[1], Pierre Morel fondateur du laboratoire de météorologie dynamique (CNRS), parle avec humour de la façon dont biais cognitifs et biais instrumentaux s'additionnent :

« On voit un réchauffement progressif qui se monte à 0,6°C en un siècle. Mais sur ce 0,6°C en un siècle, il y en a 0,4 qui sont des corrections apportées pour compenser les défauts des appareils de mesure ! Le signal est faible. S'il y en a un, il est bruité... et par conséquent la scrutation extrêmement attentive pour ne pas dire obsessionnelle de ces diagrammes de variations séculaires de tel ou tel paramètre, notamment la température est un tout petit peu... dangereuse, ... Il n'y a pas assez d'information pour en tirer des conclusions... Le climat, c'est un peu comme les tests de Rorschach, on y trouve ce qu'on y cherche. On y voit, on y trouve ce qu'on veut. Il suffit de vouloir quelque chose : on le trouve »Cet article fournit quelques exemples de la façon dont les données sont « soumises à la question » pour leur faire avouer... l'origine anthropique du réchauffement climatique.

La courbe en forme de crosse de hockey

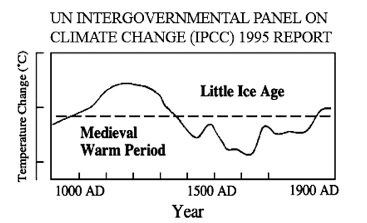

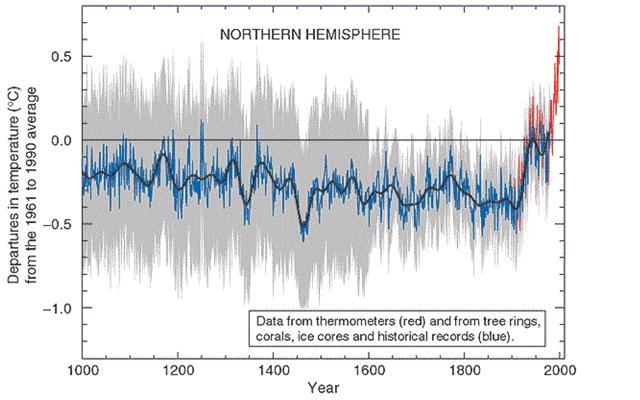

La querelle climatique s'est longtemps fixée sur la crosse de hockey, une courbe censée reproduire les variations de la température moyenne du globe depuis 1000 ans. Dans le premier rapport du GIEC (1990), le graphique du climat des 1100 années précédentes faisait apparaître une période médiévale (Optimum Médiéval) qui était un peu plus chaude que la période présente ainsi qu'une période plus froide qui s'est écoulée entre la Renaissance et le milieu du 19ème siècle, baptisée petit âge glaciaire (PAG).

L'existence d'une période plus chaude que la période actuelle, en l'absence de gaz à effet de serre anthropiques, fut considérée comme gênante par ceux qui soutenaient que le réchauffement actuel ne pouvait être expliqué que par les activités humaines. Mann et al (1998, 1999) utilisèrent des données dendrochronologiques (enregistrements de cernes d'arbres) et produisirent une reconstruction des températures de l'hémisphère Nord qui occultait l' « optimum médiéval » et le « petit âge glaciaire ».

Cette courbe connue sous le nom de crosse de hockey montrait un léger refroidissement pendant environ mille ans, aboutissant à un réchauffement rapide commençant au XIXème siècle. La courbe de Mann a été mise en avant dans le rapport suivant du GIEC (1995) suggérant que le réchauffement actuel était sans précédent depuis 1000 ans.

Cette courbe a été depuis invalidée : il est intéressant de noter que les critiques les plus pertinentes de la courbe de Mann provinrent de statisticiens extérieurs au domaine de la recherche climatique : (McIntyre et McKitrick, 2003, 2005a, b). Le 4ème rapport du GIEC ne mentionna plus la crosse de hockey, mais l'affirmation que le réchauffement actuel est sans précédent, est restée.

Et s'il n'y avait pas de hiatus, après tout !

Depuis 1998 (année d'un épisode El Niño particulièrement intense), la terre ne se réchauffe plus alors mêmes que les gaz a effet de serre (GES) n'ont pas cessé d'être répandus dans l'atmosphère. Ce plateau de température est reconnu par le GIEC sous le nom de hiatus[2]s car il s'agit d'une anomalie non prévue par ses modèles. Embarrassés par cette réalité, certains scientifiques avancent diverses hypothèses pour expliquer le « hiatus ».

La chaleur perdue serait enfouie dans les couches profondes de l'océan

Pour Kevin Trenberth [3], cette « chaleur perdue » (l'énergie supplémentaire introduite dans le système climatique qui ne se manifeste pas un réchauffement) serait enfouie dans l'océan profond. En mai 2013 Trenberth et 2 co-auteurs (Balmaseda, et Källén) ont ré-analysé les données climatique des 50 dernières années et « montré » que au cours des 10 dernières années 30 % du réchauffement des océans s'est produit en dessous de 700 m de profondeur.

Vu le caractère lacunaire des données d'observations (les balises ARGOS n'ont été déployées qu' à partir de 2007), cette théorie a nécessité une ré-analyse des données très sophistiquée (appelée « assimilation ») qui mixe données d'observations et prévisions de modèles en vue de fournir (en principe) une estimation de qualité supérieure.

Le hiatus : un artefact des mesures ?

Plus récemment (juin 2015) des scientifiques de la NOAA ont publié dans Sciences [4] une étude dans laquelle ils affirment avoir découvert 3 biais dans les mesures des températures des surfaces de la mer dont l'élimination permet d'annihiler le « hiatus ». Constatant que les températures mesurées par les bateaux sont plus élevées que celles relevées par les bouées ARGOS, celles-ci ont ainsi été ajustées à la hausse.

Selon que les mesures sur les navires ont été effectuées directement à partir des canaux d'admission du moteur ou par prélèvement de l'eau dans un seau avant cette même mesure, le résultat est très légèrement différent. Les chercheurs ont estimé ce 2ème biais et l'ont intégré à leur analyse. Enfin, ils ont pris en compte de nouvelles bases de données des températures relevées par des stations météorologiques terrestres « améliorant » ainsi la couverture spatiale de nombreuses zones, dont l'Arctique, où les températures ont augmenté rapidement ces dernières années.

Patrick J. Michaels, Richard S. Lindzen et Paul C. Knappenberger[5] ont fait observer que la correction à la hausse des bonnes données (produites par ARGOS) pour les ajuster aux « mauvaises » données » (celles des navires) était une pratique spécieuse : la densification du réseau des balises ARGOS durant les 2 décennies passées ne pouvait qu'introduire un tendance au réchauffement dans la série de données. L'introduction de températures de stations terrestres de l'arctique leur semble aussi critiquable : en effet, la plus grande partie de l'océan arctique est recouvert par la glace, même en plein été, avec une température de surface voisine de 0°C. Introduire des données terrestres dans celles de l'océan induit nécessairement un réchauffement.

L'homogénéisation des données

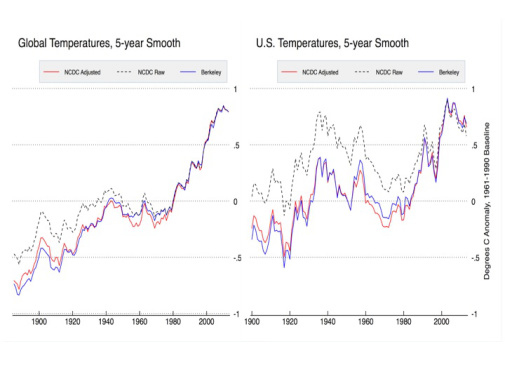

Les techniques d'homogénéisation visent à extraire le signal climatique en supprimant au mieux les ruptures d'homogénéité (changements des capteurs ou des pratiques d'observation, déplacement des sites d'observation ou modifications de leur environnement). La nécessité de retraiter les données ne fait pas de doute; ce qui est surprenant, c'est que les corrections vont toujours dans le sens du réchauffement.

Richard Lindzen Professeur de Climatologie au MIT (et auteur principal du chapitre 7 du 3ème rapport du GIEC) écrit à ce sujet [6] :

« que des corrections aient besoin d'être appliquées aux données climatiques n'est pas du tout surprenant, mais que ces corrections aillent toujours dans le sens « souhaité » est hautement improbable. Cette situation peut faire penser à une malhonnêteté évidente, mais il est tout à fait possible que beaucoup de scientifiques imaginent, dans le contexte scientifique actuel, que le rôle de la science est de confirmer le paradigme de l'effet de serre pour le changement climatique »Exemples en France et aux États-Unis.

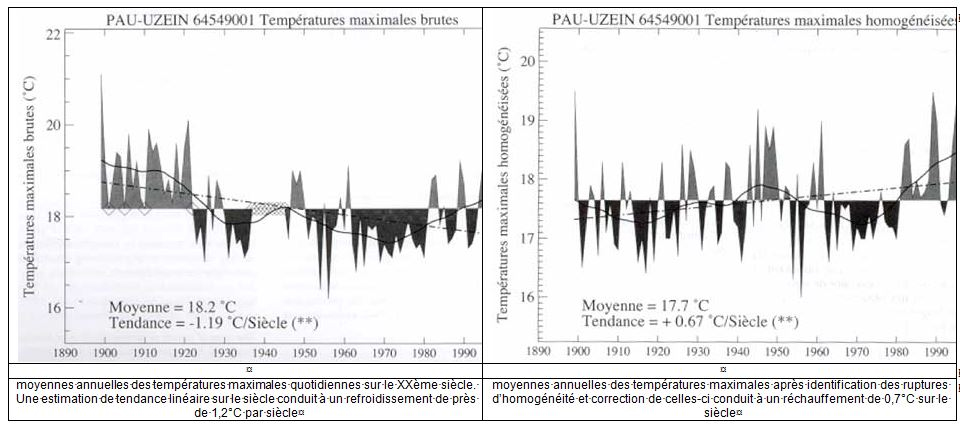

En France

Avant leur homogénéisation les moyennes annuelles des températures maximales quotidiennes enregistrées en France tout au long du 20ème siècle indiquaient un refroidissement de 1,2 °C. A la suite de l'homogénéisation c'est désormais un réchauffement général de 0,7°C qui est constaté.

Météo-France donne l'exemple de la station de Pau-Uzein pour illustrer les performances de sa méthode d'homogénéisation : [7].

Météo France indique qu'après correction, les données de température sont désormais tout à fait cohérentes avec la tendance globale au réchauffement et précise qu'on retrouve bien sur cette série chronologique les trois phases généralement observées : une croissance modérée de la température jusqu'au début des années 50, une stagnation ou une diminution jusque vers 1970, et ensuite une forte croissance.

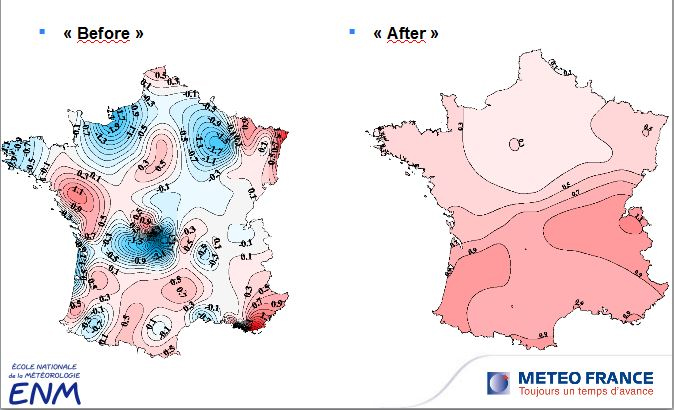

Les cartes ci-dessous illustre les résultats de l'homogénéisation au niveau de la France entière.

Aux États-Unis

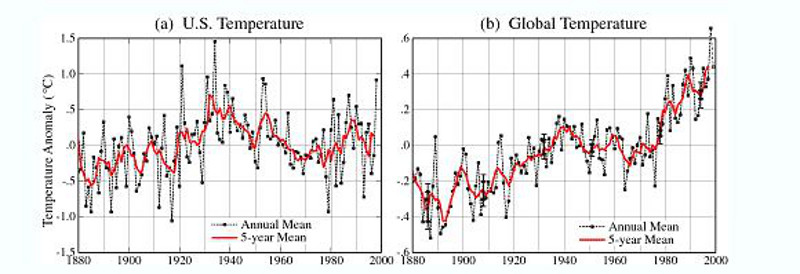

Dans un article publié en août 1999 sur le site de la NASA[8], James Hansen relève que la décade la plus chaude aux États-Unis est 1930-1940 et l'année la plus chaude 1934.

James Hansen note : aux Etats Unis il y a eu assez peu de changement de températures dans les 50 dernières années malgré les émissions de Gaz à effet de serre en rapide augmentation ; en fait il y a même eu un léger refroidissement. Comme en France l'homogénéisation aux Etats Unis a eu pour effet faire apparaître un réchauffement que montrent les courbes ci-dessous [9] :

L'homme est le principal responsable de la fonte des glaciers depuis 1990

C'est le titre d'un article du Monde.fr du 15 août 2014 en référence à une étude du glaciologue Ben Marzeion (Université d'Innsbruck) qui quantifie le pourcentage des pertes de masse des glaciers imputable aux activités humaines :

- entre 1851 et 2010 : 25% (avec une marge d'erreur de + - 35 %)

- entre 1991 et 2010 : 69% (avec une marge d'erreur de +-24 %).

Même sans connaître la méthodologie de cette étude, on imagine que les données ont carrément été suppliciées pour parvenir à de tels résultats (avec des marges d'incertitude conséquentes il est vrai). D'autant que dans une précédente étude (2012)[10], le même auteur indiquait que notre connaissance du comportement des glaciers est fortement limitée par l'insuffisance des observations ; il écrit :

« On ne dispose de mesures directes que pour 300 glaciers ; le nombre de glaciers sur lesquels les données portent sur une période de plus de 30 ans est encore plus restreint ; or le nombre total de glaciers dans le monde est supérieur à 20 000.Conclusions

... Même une accentuation de nos efforts pour augmenter le nombre d'observations ne pourrait améliorer substantiellement la situation dans les prochaines décades »

Pour conclure citons l'océanographe Carl Wunsch qui dans un article intitulé : « Climate change as an intergenerational problem » publié en mars 2013 dans PNAS[11] a écrit :

« Rares sont les scientifiques qui prétendraient pouvoir comprendre le phénomène physique même le plus trivial sans avoir observé son évolution sur les échelles de temps nécessaires...Rappelons que :

...le système climatique change à toutes les échelles de temps (de quelques années à l'âge de la terre), alors même que nous ne disposons que de données d'observations brèves et récentes ».

- Le thermomètre n'a été inventé qu'au début du 17e siècle

- Les relevés de température par satellite ont commencé en 1979

- La hausse du niveau de la mer n'est surveillée par satellite que depuis 1992

- Le déploiement complet des balises ARGOS (permettant une analyse de la température et de la salinité des eaux de 0 à 200 mètres) n'a été achevé qu'en 2007

- Les bilans de masse des glaciers du Groenland et de l'Antarctique n'ont commencé qu'au début du 21e siècle.

Carl Wunsch de conclure :

« La compréhension du changement climatique est un problème pour plusieurs générations. Les scientifiques d'aujourd'hui devraient prendre en compte les besoins des générations suivantes, plutôt que de se concentrer uniquement sur leur productivité scientifique immédiate ».Notes :

[1] Bureau des longitudes 07 octobre 2009 (http://www.canalacademie.com/ida5110-Rechauffement-planetaire-et-science-du-climat.html)

[2] Dans son 5ème rapport ( 2013), le GIEC) précisait qu'entre 1951 et 2012, la tendance moyenne au réchauffement avait été de 0,12 °C par décennie, alors qu'entre 1998 et 2012, la tendance n'avait été que de 0,05 °C par décennie

[3] Climatologue au « National Center for Atmospheric Research » (USA)

[4] Thomas Karl and al : « Possible artifacts of data biases in the recent global surface warming hiatus »

[5] http://judithcurry.com/2015/06/04/has-noaa-busted-the-pause-in-global-warming/

[6] Richard Lintzen Science du Climat : Est-elle, de nos jours, apte à répondre aux questions ? (septembre 2008)

[7] http://www.cnrs.fr/cw/dossiers/dosclim1/biblio/pigb12/05_rechauffement.htm

[8] Whither U.S. Climate? By James Hansen, Reto Ruedy, Jay Glascoe and Makiko Sato — August 1999 (http://www.giss.nasa.gov/research/briefs/hansen_07/)

[9] http://judithcurry.com/2014/07/07/understanding-adjustments-to-temperature-data/

[10] Past and future sea-level change from the surface mass balance of glaciers » (novembre 2012).

[11] http://www.pnas.org/content/110/12/4435.full

Commentaires des Lecteurs

Lettre d'Information