Toutes choses par ailleurs égales, la théorie militaire précise que la force d'un groupe armé augmente au carré de sa taille, d'où des stratégies basées soit sur le nombre, soit sur la technologie permettant de compenser un nombre inférieur de combattants mais dans les deux cas le but est soit d'atteindre un objectif, soit d'empêcher l'autre d'atteindre un objectif.

La première remise en cause fondamentale de cette approche guerrière classique fut l'avènement de la dissuasion nucléaire, le but n'étant plus d'empêcher l'autre d'atteindre un objectif mais de l'empêcher de même essayer. D'où l'intérêt évident pour les petites puissances type Pakistan, Corée du Nord, Iran de se munir de la bombe A afin de dissuader toute offensive de la part de puissances bien supérieures. Mais même dans le cadre nucléaire la décision d'action revient à l'opérateur humain, et des catastrophes ont été évitées du fait de la capacité de contextualisation d'un humain.

Ce fut JFK lors de la crise des missiles de Cuba de 1962, quand il fut capable de « rentrer » dans la tête de Khrouchtchev et de comprendre que le problème pouvait se résoudre en diminuant la pression militaire de l'OTAN envers l'URSS, menant ainsi à une période de détente. Ce fut Stanislav Petrov en 1983 qui refusa d'accepter telle quelle l'alerte d'une attaque nucléaire américaine lancée par le système anti-missiles soviétique. Il avait senti que le faible nombre de missiles et le manque de contexte pour une telle attaque pointaient vers une fausse alerte, ce qui était effectivement le cas.

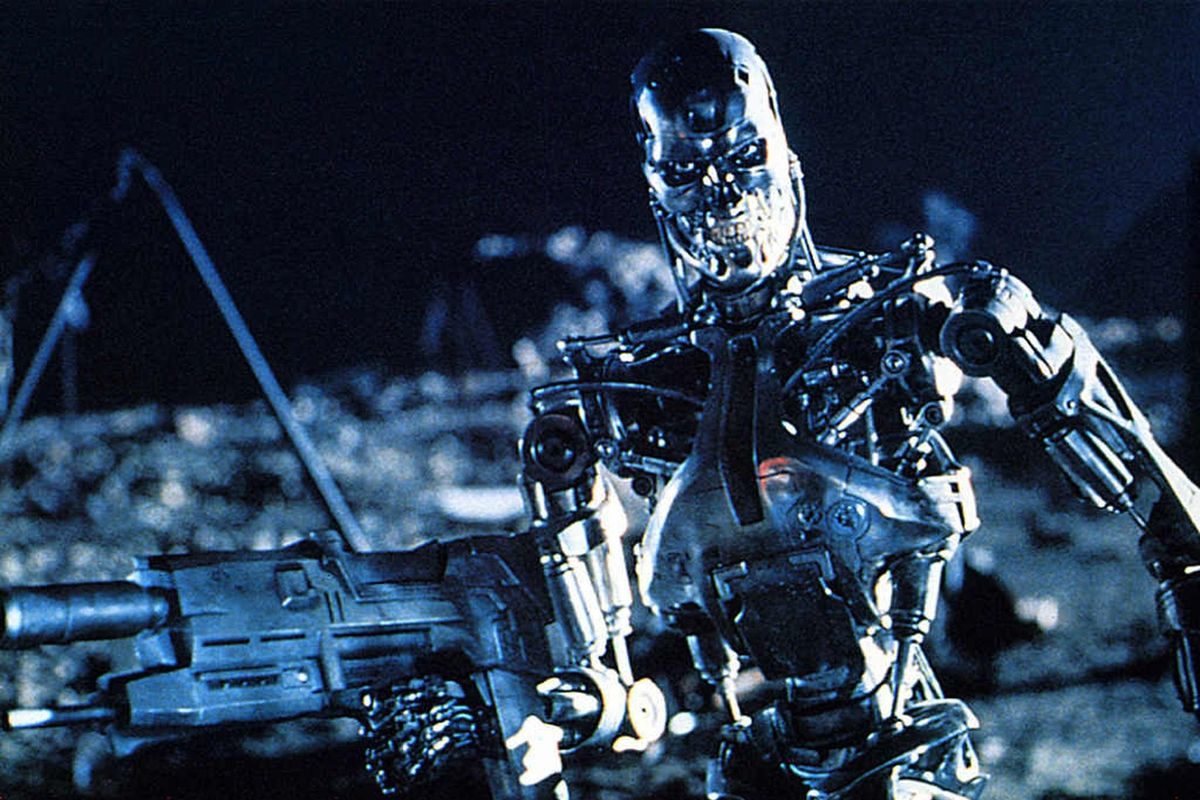

Nous en sommes désormais à une seconde remise en cause fondamentale de notre manière de faire la guerre : le remplacement de l'opérateur humain, du soldat par des machines dotées d'intelligence artificielle (IA). Cette évolution et ses conséquences possibles ont déjà été présentées dans le billet « Intelligence artificielle, arme fatale du futur » (1), il s'agit ici de pointer plus précisément les deux éléments intrinsèques au développement de l'IA militaire: la logique de l'attaque préventive ou first strike, et la création de l'ennemi perpétuel.

L'objectif d'une IA de combat est l'identification des faiblesses de l'ennemi et l'optimisation du parti que l'on peut en tirer, optimisation menant logiquement à l'attaque dès lors que l'on sait qu'elle sera efficace. C'est ainsi que fonctionnent les drones tueurs autonomes qui survolent certaines zones de combat en Afghanistan et ailleurs. C'est ainsi que fonctionneront les systèmes militaires en général dans un futur proche, du simple fait qu'à partir du moment ou deux systèmes à base d'IA se confrontent, les choses vont tellement vite qu'il n'y a plus de temps physique suffisant pour qu'un humain intervienne.

De ceci découle la conclusion logique qu'une IA autonome de combat n'aura d'autre solution que la destruction d'un opposant dès qu'il en percevra la possibilité, l'inaction risquant de mener à sa propre destruction. Nous sommes donc à l'opposé de la dissuasion nucléaire qui visait à contrer l'idée même de lancer des attaques, et en même temps à l'aube d'une nouvelle course aux armements à base d'IA.

Comme toujours le développement d'outils militaires se répercute au niveau civil. La militarisation de la police américaine (2) est directement liée au développement de méthodes et d'outils militaires dans le cadre des guerres menées par les USA et l'Occident au Moyen-Orient depuis près de vingt ans. Ce mouvement de militarisation policière existe partout, transformant les forces de police en forces d'occupation, des robocops armés et blindés opérant en « territoire ennemi » au sein de nos villes et campagnes.

Les drones de combat se retrouvent, dans une version certes moins létale, aux mains des forces de police tandis que les techniques de cyberguerre et d'espionnage sophistiqué, visant initialement les ennemis extérieurs, se retournent aujourd'hui contre l'ensemble des populations sous prétexte de « sécurité ». La Chine actuelle nous offre déjà l'image de notre futur proche: une surveillance omniprésente associée à un système de notation et de contrôle du comportement de chaque citoyen, une dystopie dictatoriale dopée à la haute technologie et à l'intelligence artificielle (3).

Tout comme un Etat policier considère, par définition, que l'ensemble de sa population constitue un risque, un système technologique de contrôle social considère l'ensemble de la population en tant que menace potentielle, créant ainsi le principe d'un ennemi perpétuel agissant aussi bien à l'intérieur qu'à l'extérieur de ses frontières. L'IA intégrée à ce type de système aura donc pour tâche principale de déceler toutes traces de comportement « dangereux » chez chaque individu, et d'agir ensuite pour éliminer ce danger.

C'est déjà ce que font aujourd'hui les services de police, mais l'IA promet de le faire avec une profondeur, une rapidité et une précision actuellement circonscrite aux rêves humides des technocrates. Ceci peut sembler fabulateur et exagéré, mais il suffit de considérer un exemple très parlant pour se rendre compte que l'IA nous fait effectivement rentrer dans une nouvelle dimension: lors du tournoi de Go mené en 2016 entre l'IA DeepMind de Google et le champion du monde Lee Sedol (qui fut battu 4-1) (4), l'IA gagna une des manches en jouant un coup (le fameux « coup 37 ») totalement novateur, totalement imprévu par les observateurs ainsi que par Sedol lui-même.

On peut voir la surprise des observateurs lorsque l'IA joue cette pierre (l'IA est en noir), et on entend à la fin du clip que Sedol a carrément quitté la pièce, traumatisé par ce coup qu'il ne comprend pas.

L'IA a joué ce coup car il a pu déterminer statistiquement, sur base de la mémoire précise de centaines de milliers de parties qu'il a lui-même jouées et des parties que Sedol a jouées contre d'autres humains, que poser cette pierre à cet endroit allait par la suite lui permettre de gagner, et de fait. Aucun joueur humain ne l'aurait fait car aucun humain n'a la capacité d'analyser précisément autant de parties, et encore moins d'en tirer des statistiques en temps réel. Et ça c'est une IA de jeu de 2016, un bébé par rapport à ce que les IA militaires ou policières seront d'ici quelques années.

De chaque déplacement, de chaque retrait bancaire, de chaque promenade sur internet, de chaque publication sur les réseaux sociaux les IA policières tireront des schémas et des prédictions quand à nos motivations, nos petits secrets, nos petites ou grosses déviances par rapport à la norme et informera l'autorité en conséquence. Autorité qui pourra alors soit nous intercepter, soit nous manipuler. Et c'est déjà le cas, même si la manipulation est encore plutôt du fait d'intérêts privés ou politiciens (5) mais la contagion se répand comme un feu de foret, chaque pays investissant de plus en plus lourdement dans l'IA - et notamment les pays à fort enjeu militaire et policier avec les USA, la Chine et Israël formant le trio de tête (6).

A cette vision un peu sombre on peut opposer l'idée que l'IA, étant au départ programmée par des humains, pourrait aussi faire la promotion du bien, de la liberté et de la paix mais ceci se heurte à un problème fondamental : les notions de bien, de vertu, de compassion, de liberté n'existent que dans un contexte civilisationnel composé d'êtres biologiques passablement irrationnels et sentimentaux, des concepts totalement étrangers à l'IA.

Certes on peut toujours programmer des systèmes de récompense au sein d'une IA qui la pousse à choisir une solution « humaine » plutôt que purement rationnelle, et ceci peut fonctionner dans des cas simples où il n'existe pas d'ambiguïté ni de conflits entre différentes « bonnes solutions », mais ces cas sont rares.

Les lois de la robotique d'Isaac Asimov ne sont qu'un vœu pieu car dès lors que des oppositions existent entre des solutions d'égal mérite moral, par exemple le droit de manifester contre le droit à la protection de la propriété privée, ou tuer un dangereux terroriste au prix de tuer en même temps quelques innocents, et dès lors que les décisions face à ces situations impactent d'autres situations que seule l'IA peut statistiquement prévoir, la décision de l'IA n'aura plus aucun lien avec une quelconque position morale humaine. Elle sera -comme le coup 37 de DeepMind - le fruit d'un processus qui nous échappe complètement.

L'IA ne fait malheureusement pas partie du débat politique ou médiatique mais il me paraît évident, désormais, que tout candidat politique aujourd'hui doit être précisément questionné sur ses intentions en matière de développement, de contrôle et de mise en oeuvre par l'Etat de systèmes à base d'intelligence artificielle, et a fortiori concernant les systèmes de combat et de police.

Notes:

(1) https://zerhubarbeblog.net/2018/03/03/intelligence-artificielle-arme-fatale-du-futur/

(2) https://zerhubarbeblog.net/2015/11/18/surarmement-policier-ou-le-risque-de-la-force-doccupation/

(3) https://zerhubarbeblog.net/2018/04/19/intelligence-artificielle-le-cas-chinois/

(4) https://zerhubarbeblog.net/2017/10/19/alphago-zero-le-futur-en-jeu/

(5) https://zerhubarbeblog.net/2018/04/12/de-facebook-au-brexit-la-course-au-profil/

(6) https://medium.com/@bootstrappingme/global-artificial-intelligence-landscape-including-database-with-3-465-ai-companies-3bf01a175c5d

Commentaires des Lecteurs

Lettre d'Information